L’intelligence artificielle (IA) intègre de plus en plus d’applications en santé. Elle doit tenir compte de nombreuses disciplines : l’ingénierie logicielle (fiabilité, robustesse, sécurité), l’obsolescence des connaissances mais aussi le droit, l’éthique, car une grande variété d’algorithmes, plus ou moins opaques, traitent des données personnelles. S’appuyant sur les différents axes régissant l’IA et l’éthique médicale, un indicateur d’évaluation du risque éthique potentiel des technologies IA est établi.

L’informatique et les systèmes d’information médicaux des années 1970-80 posaient déjà des problèmes juridiques et éthi-ques.1-3 Les fondements de l’intelligence artificielle (IA) datent pourtant des années 1950, avec les systèmes experts aux États-Unis MYCIN (identification d’infections bactériennes)4 puis en France.5-8 Depuis 2020, l’intelligence artificielle connaît un nouvel essor qui bouleverse toutes les activités humaines et particulièrement l’exercice de la médecine, avec l’avènement des systèmes multi-agents, du deep learning (extension des réseaux de neurones) et actuellement de l’IA autonome ou IA générative avec des chatbots comme ChatGPT.9 La méthode d’évaluation des risques éthiques de l’utilisation de l’intelligence artificielle en médecine décrite dans cet article s’adresse aussi bien aux « médecins des villes » qu’aux « médecins des champs », pour paraphraser Nicole Léry, à qui je rends ici hommage pour son enseignement et son œuvre qui rendent aujourd’hui possible cette contribution.10,11

Historique de l’éthique médicale

Depuis les années 1980, les médecins, qu’ils travaillent en milieu hospitalier, en cabinet en ville ou à la campagne, se réunissent pour réfléchir à leurs pratiques. Ils s’interrogent sur les effets éventuellement néfastes sur la vie de chaque patient qui doit nécessairement consentir et adhérer aux actes effectués sur son corps et/ou son psychisme. Par ailleurs, l’offre de soins est contrainte par les moyens personnels du patient, ses assurances, la solidarité de la société... La réflexion sur l’éthique médicale apparaît dès que des questions difficiles émergent dans la relation de soin. La recherche médicale propose sans cesse de nouvelles technologies alors que des pathologies émergent. Ainsi, la réflexion éthique est-elle dynamique et doit continuellement s’adapter.

On distingue deux catégories d’éthique médicale : celle, institutionalisée par le Conseil consultatif national d’éthique (CCNE) pour les sciences de la vie et de la santé, qui réfléchit globalement à des grands problèmes généraux12 et l’éthique de terrain, qui se nourrit des expériences des praticiens confrontés à des questions singulières et qui est proche de la médecine clinique.10,11,13,14 Ce besoin a conduit les Drs Nicole Léry et Louis Léry à proposer à Lyon, dès les années 1980, une consultation d’éthique médicale d’abord à l’hôpital Édouard-Herriot, puis à l’hôpital du Vinatier dans le cadre de l’association Santé, éthique et libertés (SEL).

On distingue deux catégories d’éthique médicale : celle, institutionalisée par le Conseil consultatif national d’éthique (CCNE) pour les sciences de la vie et de la santé, qui réfléchit globalement à des grands problèmes généraux12 et l’éthique de terrain, qui se nourrit des expériences des praticiens confrontés à des questions singulières et qui est proche de la médecine clinique.10,11,13,14 Ce besoin a conduit les Drs Nicole Léry et Louis Léry à proposer à Lyon, dès les années 1980, une consultation d’éthique médicale d’abord à l’hôpital Édouard-Herriot, puis à l’hôpital du Vinatier dans le cadre de l’association Santé, éthique et libertés (SEL).

Naissance de l’IA et application de l’éthique médicale

Après avoir réalisé l’un des premiers systèmes experts d’antibiothérapie médicale7 au cours de ma thèse de médecine, je me suis intéressé très tôt aux problèmes d’éthique posés par l’utilisation de l’informatique en médecine.3,5 Avec Nicole Léry, dans le cadre de nos recherches sur l’IA appliquée à la médecine, nous avons proposé un système d’aide à la décision en éthique médicale fondé sur la « fleur relationnelle » et la « spirale décisionnelle » conçues par Nicole Léry, dont nous avons formalisé les étapes et donné un exemple d’utilisation concernant la vaccination.10,11

Nous montrions déjà que le raisonnement clinique fondé sur la sémiologie était assez proche du raisonnement à partir de cas (RàPC) et des systèmes multi-agents (SMA) autour desquels se sont formés des communautés de chercheurs en IA. Après le décès de Nicole, notre collaboration a continué avec Louis Léry, jusqu’à sa disparition en 2009.13,14 L’IA en médecine a connu depuis une amélioration considérable enrichie de nouveaux modèles, méthodes, outils : applications, plateformes, objets connectés, télémédecine, rendus possibles par le développement d’internet.

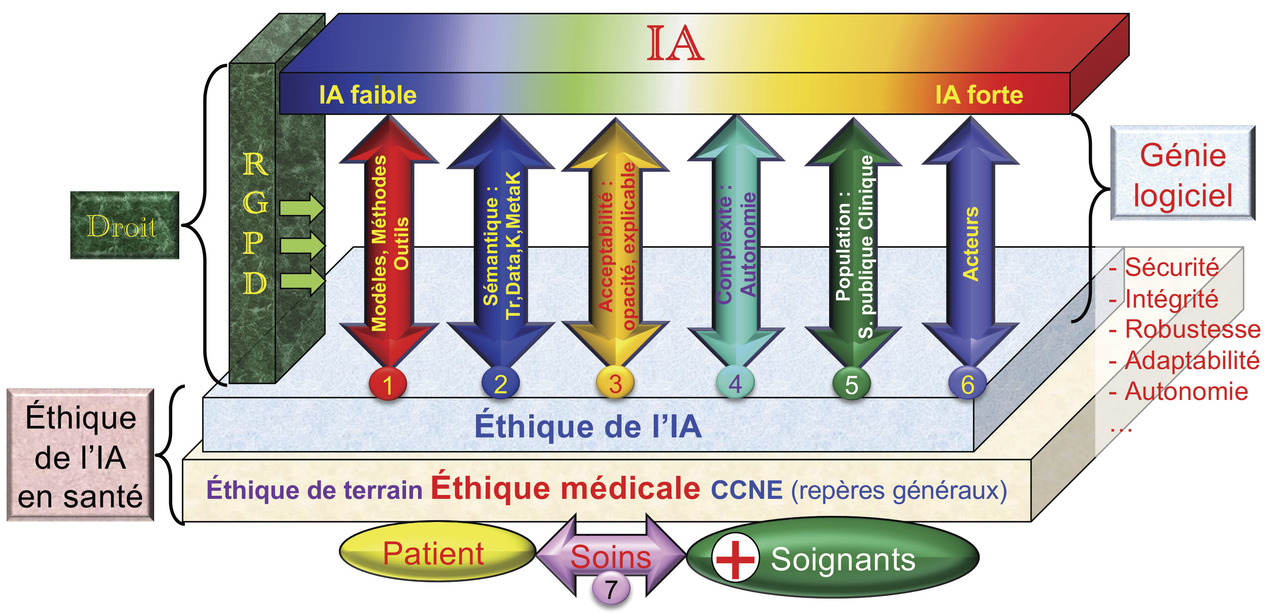

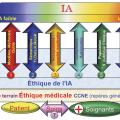

Dans ce contexte, nous proposons une méthode d’évaluation éthique des bénéfices et des risques de cette nouvelle offre IA en santé15 (fig. 1 ) qui repose sur la relation de soin (soignants-patient, axe 7) et le socle d’éthique médicale clinique proposé initialement avec Nicole et Louis Léry. Afin de permettre aux médecins praticiens d’évaluer par eux-mêmes, simplement, la pertinence éthique des nouvelles applications de l’IA en santé qui leur sont proposées, nous fournissons un ensemble de critères (fig. 1 ) qui comporte six axes situés entre :

Nous montrions déjà que le raisonnement clinique fondé sur la sémiologie était assez proche du raisonnement à partir de cas (RàPC) et des systèmes multi-agents (SMA) autour desquels se sont formés des communautés de chercheurs en IA. Après le décès de Nicole, notre collaboration a continué avec Louis Léry, jusqu’à sa disparition en 2009.13,14 L’IA en médecine a connu depuis une amélioration considérable enrichie de nouveaux modèles, méthodes, outils : applications, plateformes, objets connectés, télémédecine, rendus possibles par le développement d’internet.

Dans ce contexte, nous proposons une méthode d’évaluation éthique des bénéfices et des risques de cette nouvelle offre IA en santé15 (

- en haut, la couche d’intelligence artificielle qui regroupe des systèmes d’IA faible à l’IA forte dont certains aspects ne sont encore que des perspectives ;

- en bas, l’éthique de l’IA en santé reposant sur deux couches : la couche d’éthique de l’IA qui, dans le domaine de la santé, doit nécessairement reposer sur la couche d’éthique médicale regroupant des aspects liés à la déontologie et à la spirale de décision décrite plus loin (modèle Léry-Colloc)10,11,13,14 qui s’appuie sur l’axe 7 (la relation patient-soignant) ;

- à gauche, on trouve les références législatives (règlement général sur la protection des données [RGPD], la responsabilité…). Le RGPD complète la loi Informatique et libertés du 6 janvier 1978 et oblige l’utilisateur à l’élaboration du registre de traitement des données personnelles des patients selon tous les axes de la

figure 1 ; - à droite, on trouve des critères de génie logiciel (sécurité, intégrité, robustesse, adaptabilité, autonomie, reproductivité…).

- Le modèle d’évaluation comprend les sept axes décrits ci-dessous.

Axe 1 : modèles, méthodes et outils de l’IA

L’axe 1 recense les principales technologies actuelles de l’IA et évalue leur degré de complexité et d’autonomie (Cx : de 5 à 9, voir axe 4) et leur degré d’opacité (Op : de 0 à 4, voir axe 3).

Les systèmes d’aide à la décision fondés sur les arbres de décision, les règles de production, les réseaux bayésiens, la logique floue, le raisonnement à partir de cas sont de niveau de complexité 6 ou 7 et d’opacité 0 ou 1, ils sont capables d’expliquer les raisonnements effectués.

Les systèmes multi-agents réactifs (algorithmes fourmis), les réseaux de neurones ont une complexité égale à 7 et une opacité de 2 ou 3 ; ils sont donc incapables d’expliquer leur fonctionnement.

Le deep learning (apprentissage profond) et l’IA générative (Cx = 8 et Op = 3) sont à la fois plus complexes et ne fournissent pas de justification des résultats obtenus. C’est le cas des chatbots (agents conversationnels autonomes) comme ChatGPT.9

Les espaces vectoriels flous temporels sont d’une complexité analogue mais présentent l’avantage d’expliquer leur mode de fonctionnement avec des diagrammes UML (unified modeling language) qui reposent sur la sémiologie médicale.18,21

Plus de détails concernant les modèles, méthodes et outils de l’IA peuvent être consultés dans les références.16-22

Les systèmes d’aide à la décision fondés sur les arbres de décision, les règles de production, les réseaux bayésiens, la logique floue, le raisonnement à partir de cas sont de niveau de complexité 6 ou 7 et d’opacité 0 ou 1, ils sont capables d’expliquer les raisonnements effectués.

Les systèmes multi-agents réactifs (algorithmes fourmis), les réseaux de neurones ont une complexité égale à 7 et une opacité de 2 ou 3 ; ils sont donc incapables d’expliquer leur fonctionnement.

Le deep learning (apprentissage profond) et l’IA générative (Cx = 8 et Op = 3) sont à la fois plus complexes et ne fournissent pas de justification des résultats obtenus. C’est le cas des chatbots (agents conversationnels autonomes) comme ChatGPT.9

Les espaces vectoriels flous temporels sont d’une complexité analogue mais présentent l’avantage d’expliquer leur mode de fonctionnement avec des diagrammes UML (unified modeling language) qui reposent sur la sémiologie médicale.18,21

Plus de détails concernant les modèles, méthodes et outils de l’IA peuvent être consultés dans les références.16-22

Axe 2 : sémantique

L’axe 2 (traces numériques, données, connaissances, méta-connaissances), concerne la sémantique.

La trace numérique est le résultat d’une action de l’utilisateur, laissée intentionnellement ou non sur le Net (clic sur un site). Son interprétation lui attribue du sens et la transforme en signe qui renseigne sur ses préférences, émotions… L’interprétation transforme la trace en donnée quand l’utilisateur est identifié.

La donnée est une caractéristique ou une propriété d’un utilisateur, d’un patient, d’un acteur, d’un objet et elle est stockée sur un support numérique.

Les connaissances sont des conduites à tenir, des méthodes réputées efficaces pour résoudre un problème, décrire des situations ; elles sont indépendantes des patients, donc anonymes.

Les méta-connaissances déterminent comment choisir les connaissances pour résoudre un problème (exemples : les étapes d’un diagnostic, le choix des stratégies thérapeutiques).

La trace numérique est le résultat d’une action de l’utilisateur, laissée intentionnellement ou non sur le Net (clic sur un site). Son interprétation lui attribue du sens et la transforme en signe qui renseigne sur ses préférences, émotions… L’interprétation transforme la trace en donnée quand l’utilisateur est identifié.

La donnée est une caractéristique ou une propriété d’un utilisateur, d’un patient, d’un acteur, d’un objet et elle est stockée sur un support numérique.

Les connaissances sont des conduites à tenir, des méthodes réputées efficaces pour résoudre un problème, décrire des situations ; elles sont indépendantes des patients, donc anonymes.

Les méta-connaissances déterminent comment choisir les connaissances pour résoudre un problème (exemples : les étapes d’un diagnostic, le choix des stratégies thérapeutiques).

Axe 3 : acceptabilité, opacité, explicabilité

L’axe 3 décrit le degré d’acceptabilité et d’opacité, soit l’« explicabilité des algorithmes » liée avant tout aux technologies et raisonnements mis en œuvre et aux motivations des acteurs : fournisseurs, concepteurs, utilisateurs en rapport avec l’obligation d’expliquer les traitements conformément au RGPD et à la Commission nationale de l’informatique et des liberté (CNIL). Dans les « boîtes » noires statiques (Op = 3), seules les entrées et les sorties du système sont connues. Ces algorithmes sont des approximateurs : ils recherchent des similarités sans les expliquer. Dans les « boîtes noires dynamiques », le système est capable de se modifier lui-même (Op = 4), leur évolution potentielle n’est ni déterminée ni prévisible. Dans les « boîtes blanches », les étapes de décision sont décrites (Op = 0) par des diagrammes de cas d’utilisation et d’activités UML (décrivant les activités réalisées par un système). Les « boîtes grises » sont intermédiaires (1 ou 2), les entrées et sorties sont connues mais certaines étapes sont occultées.

Axe 4 : complexité et autonomie

L’axe 4 évalue la complexité et l’autonomie des dispositifs d’IA à l’aide de l’échelle de complexité des systèmes de Jean-Louis Le Moigne, qui comprend neuf niveaux.15,17,23 Il détermine si le dispositif d’IA est piloté par un soignant ou s’il s’agit d’un dispositif autonome. Dans tous les cas, il faut préciser qui est l’utilisateur final.

Les niveaux 1 à 5 définissent un système autorégulé.

Le niveau 6 est le modèle OID (opérant, information, décision) de système d’information classique implanté par une base de données.

Le niveau 7 est doté d’un système qui coordonne à chaque instant les activités des logiciels répartis sur un réseau ; on parle d’IA distribuée.

Le niveau 8 est doté d’un système d’imagination qui conçoit de nouvelles décisions possibles : le système est capable d’inventer seul de nouvelles méthodes de résolution de problèmes en médecine (diagnostic, traitements, par exemple).

Au niveau 9, le système se finalise, il sait évaluer la pertinence de sa décision, c’est-à-dire déterminer les aspects positifs et négatifs de ses actions passées pour lui-même et son environnement. Il peut être doté d’émotions et même d’un psychisme artificiel. Il devient autonome, capable de fixer par lui-même ses objectifs, comme un robot qui serait proche de posséder une pensée humaine. Ce type de système d’IA n’existe pas encore ou seulement sous la forme de prototypes partiels.

Les niveaux 1 à 5 définissent un système autorégulé.

Le niveau 6 est le modèle OID (opérant, information, décision) de système d’information classique implanté par une base de données.

Le niveau 7 est doté d’un système qui coordonne à chaque instant les activités des logiciels répartis sur un réseau ; on parle d’IA distribuée.

Le niveau 8 est doté d’un système d’imagination qui conçoit de nouvelles décisions possibles : le système est capable d’inventer seul de nouvelles méthodes de résolution de problèmes en médecine (diagnostic, traitements, par exemple).

Au niveau 9, le système se finalise, il sait évaluer la pertinence de sa décision, c’est-à-dire déterminer les aspects positifs et négatifs de ses actions passées pour lui-même et son environnement. Il peut être doté d’émotions et même d’un psychisme artificiel. Il devient autonome, capable de fixer par lui-même ses objectifs, comme un robot qui serait proche de posséder une pensée humaine. Ce type de système d’IA n’existe pas encore ou seulement sous la forme de prototypes partiels.

Axe 5 : populations source et cible

La base de connaissances du dispositif IA est-t-elle fondée sur des statistiques de population ? Le critère correspond à la cardinalité de la population source de l’apprentissage du système d’IA selon un facteur d’échelle : 5 pour internationale ; 4 pour nationale ; 3 pour régionale ; 2 pour locale (un hôpital, un cabinet de praticien) ou 1 pour quelques patients (maladie orpheline) où cha-que cas unique est décrit avec son histoire indexé dans une base de cas. Le raisonnement à partir de cas calcule une distance entre un nouveau cas et ceux déjà stockés dans la base.13,14,17,19

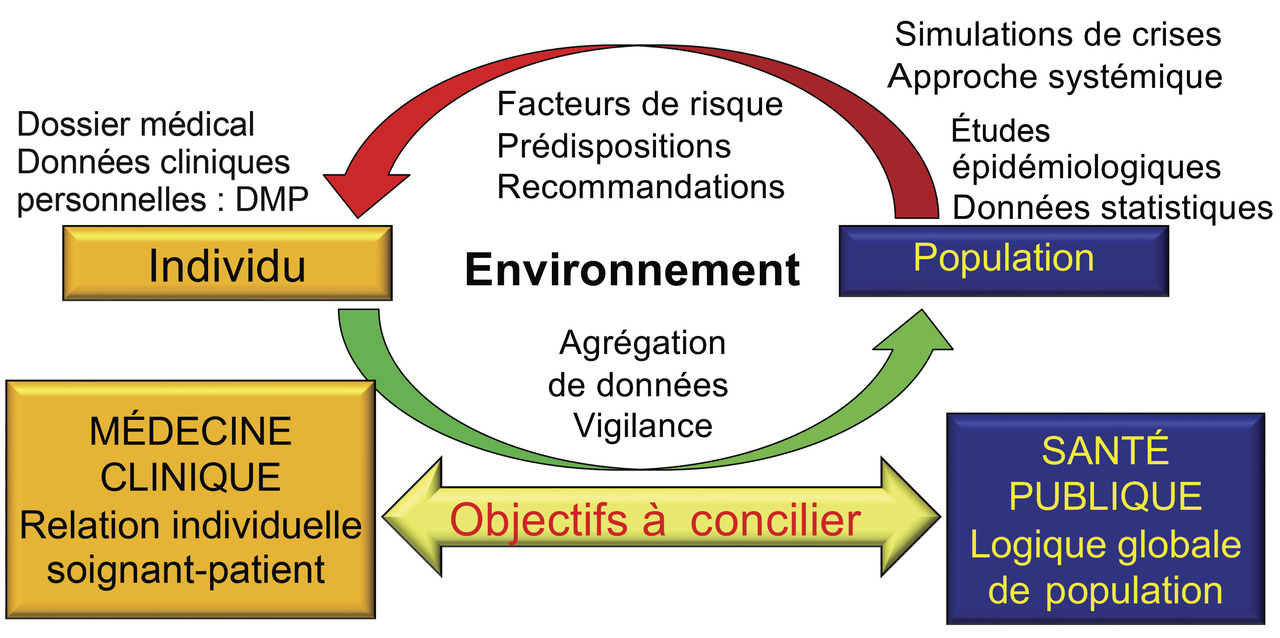

La population cible est celle qui concerne l’utilisation de l’application. S’agit-il d’une IA clinique individuelle utilisée par un médecin ou un soignant dans la relation de soin : consultation concernant un patient (fig. 2 partie gauche) ? ou d’une IA de prévention (vaccination, médecine scolaire) ou de dépistage (grippe, Covid-19) dans le cadre d’une activité de santé publique (fig. 2 partie droite) ? Quoi qu’il en soit, la population cible doit être incluse ou égale à la population source de la base de connaissances. Par exemple, une base de connaissances élaborée aux États-Unis ne conviendra pas pour une IA réalisée en Europe ou en Afrique, car ces populations ont des modes de vie très différents.

La population cible est celle qui concerne l’utilisation de l’application. S’agit-il d’une IA clinique individuelle utilisée par un médecin ou un soignant dans la relation de soin : consultation concernant un patient (

Axe 6 : acteurs

L’axe 6 concerne les acteurs, leurs rôles, leurs motivations, leurs moyens selon l’approche quintilienne (qui décrit une situation sous tous les angles) répondant aux questions suivantes : qui fait quoi, pourquoi, avec quoi, comment, où et quand ?

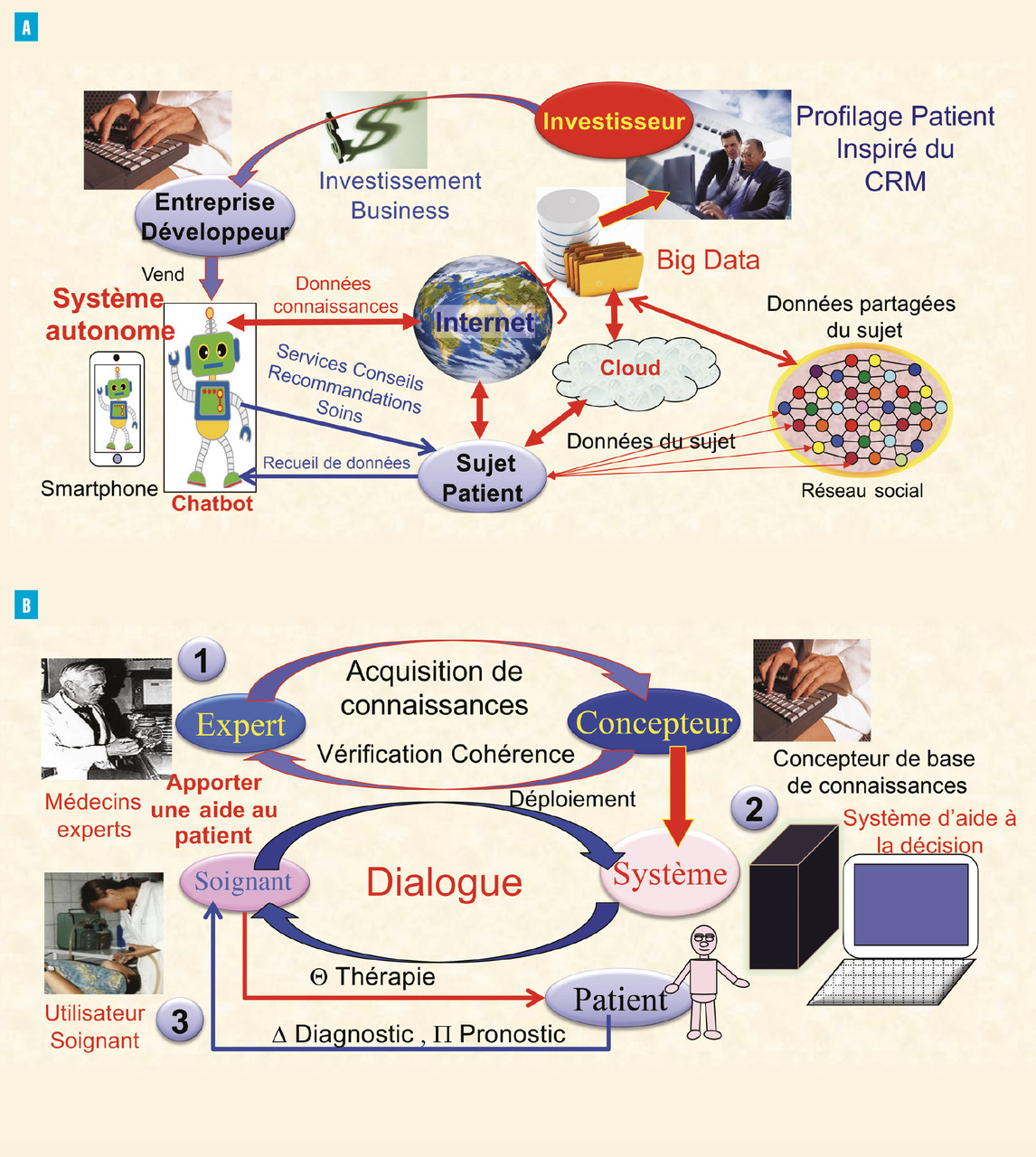

Cet axe nécessite de classer les acteurs et leurs rôles : personnes morales et physiques, investisseurs, fournisseurs, expert, utilisateur soignant, utilisateur patient, afin de déterminer les responsabilités de chacun (fig. 3 ).

Lafigure 3A décrit la situation dans laquelle un système d’IA autonome est alimenté par des données issues d’internet et du Big Data pour élaborer des conseils à destination du patient. Le système établit le profil et fournit des réponses aux questions du patient sans l’intermédiaire d’un soignant. Cette solution tend à évincer les soignants de la relation de soin. Elle pose des problèmes de responsabilité, de déontologie et d’éthique et, en particulier, de l’interprétation des réponses fournies par le patient.

La figure 3B décrit un système d’aide à la décision dans lequel un consortium d’experts élabore une base de connaissances à destination de professionnels de santé utilisateurs qui soignent un patient. L’utilisateur est le médecin ou un soignant.

Un hub de connaissances partage des connaissances anonymes consolidées réalisées par des experts médicaux avec des fournisseurs d’IA, ce qui est plus sûr qu’un hub de données qui partage des données de patients pseudonymisés recueillies hors contexte et qui peuvent être réidentifiées secondairement à l’aide de traces laissées par les patients sur internet, notamment en cas de maladies rares.

Cet axe nécessite de classer les acteurs et leurs rôles : personnes morales et physiques, investisseurs, fournisseurs, expert, utilisateur soignant, utilisateur patient, afin de déterminer les responsabilités de chacun (

La

La

Un hub de connaissances partage des connaissances anonymes consolidées réalisées par des experts médicaux avec des fournisseurs d’IA, ce qui est plus sûr qu’un hub de données qui partage des données de patients pseudonymisés recueillies hors contexte et qui peuvent être réidentifiées secondairement à l’aide de traces laissées par les patients sur internet, notamment en cas de maladies rares.

Axe 7 : la relation de soin

Récemment, la réalisation de véhicules autonomes a conduit les informaticiens à s’interroger et à proposer une éthique de l’IA et des algorithmes.24 Toutefois, lorsque l’IA est utilisée en médecine, le patient doit rester au centre de la relation de soin ; l’éthique de l’IA en médecine doit s’appuyer sur les repères juridiques, notamment de la responsabilité, du RGPD et de l’éthique médicale. L’axe 7 représente la relation de soin entre le patient et les soignants, reposant sur la « fleur relationnelle » du patient et du soignant.13-16 Cette fleur correspond à toutes les personnes (aux niveaux familial, professionnel, amical...) et organismes avec lesquels ils sont en relation, et le modèle de décision en éthique médicale.13-16 Sont tour à tour examinés les compétences techniques des soignants (les savoir-faire), l’équation (bénéfices, risques, coûts) des actes réalisés, la loi, la jurisprudence, la déontologie, les conseils du CCNE, les chartes et ensuite les convictions, les croyances et, selon les capacités du patient, son consentement quand c’est possible et/ou avec les membres de la fleur relationnelle du patient (1er, 2e, 3e cercle) pour aboutir à une décision collégiale sur la conduite pratique à tenir.

Le parcours de l’ensemble du cycle pour un patient enrichit l’expérience (consultations d’éthique) et la connaissance nourrit la base de cas du système en vue de futures délibérations dans des cas similaires.11,19

L’IA ne peut échapper aux règles d’exercice de l’art médical, et lorsque le praticien utilise l’IA, il engage sa responsabilité de la même manière que lorsqu’il utilise un autre outil, chirurgical par exemple. Dans le cas où le patient est utilisateur direct d’un système d’IA autonome, la responsabilité du concepteur d’un système d’IA défectueux peut être recherchée.

Le parcours de l’ensemble du cycle pour un patient enrichit l’expérience (consultations d’éthique) et la connaissance nourrit la base de cas du système en vue de futures délibérations dans des cas similaires.11,19

L’IA ne peut échapper aux règles d’exercice de l’art médical, et lorsque le praticien utilise l’IA, il engage sa responsabilité de la même manière que lorsqu’il utilise un autre outil, chirurgical par exemple. Dans le cas où le patient est utilisateur direct d’un système d’IA autonome, la responsabilité du concepteur d’un système d’IA défectueux peut être recherchée.

Indicateur d’évaluation des risques éthiques des systèmes d’IA en médecine

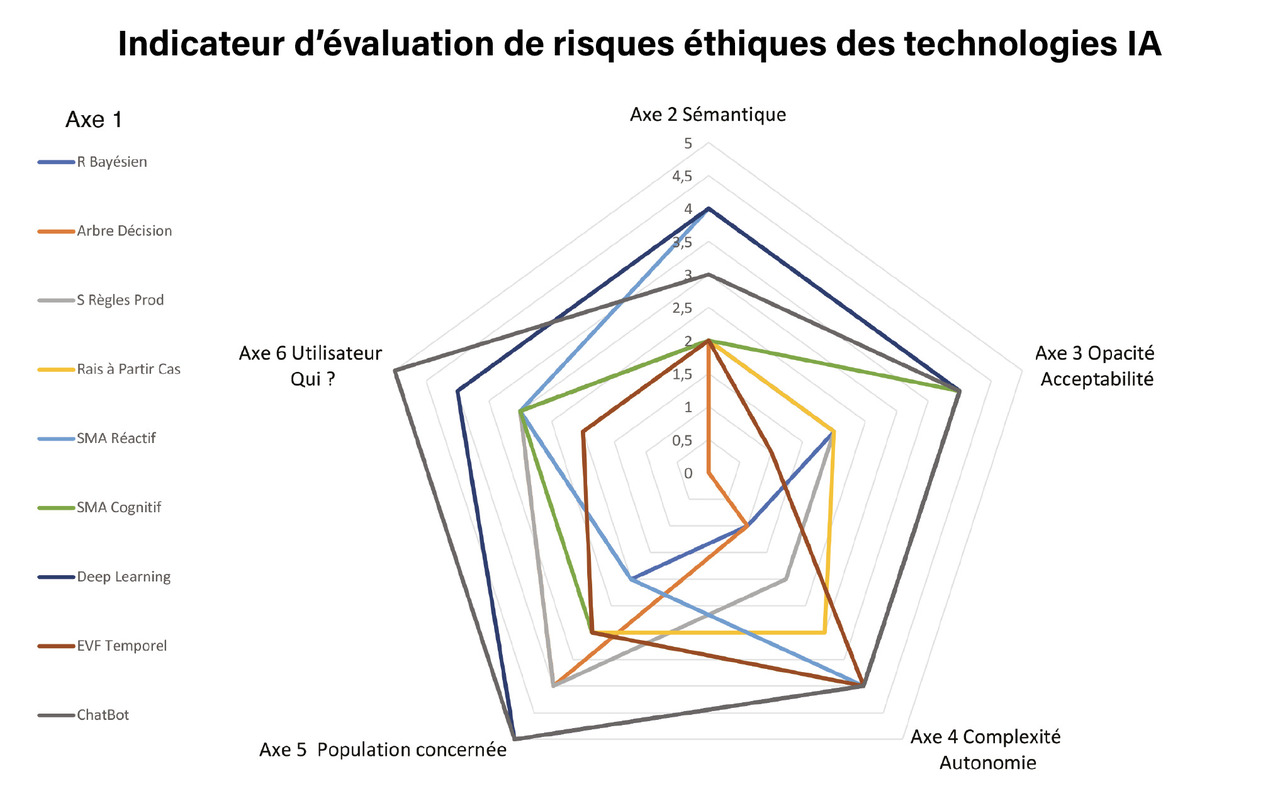

Un indicateur d’évaluation du risque éthique potentiel des technologies IA (fig. 4 ) est développé selon les différents modèles, méthodes et outils de l’IA de l’axe 1 (lignes colorées). Ce premier indicateur définit les risques éthiques de l’IA (premier axe) proportionnellement à la surface du diagramme radar des autres axes (sémantique ; opacité et acceptabilité ; complexité et autonomie ; population cible ; acteurs).

Sur l’axe 2, les méta-connaissances, connaissances, sont moins sensibles que les données et traces du patients.

L’axe 3 évalue la transparence des algorithmes comme plus acceptable que les boîtes noires opaques et dynamiques dont on ne maîtrise ni l’évolution ni les finalités.

L’axe 4 renumérote de 1 à 5 les niveaux de 5 à 9 de l’échelle de complexité des systèmes de Jean-Louis Le Moigne.23,16,17

L’axe 5 est évalué selon la population source des données utilisées par l’algorithme.

L’axe 6 décrit les utilisateurs. Les utilisations de l’IA les plus à risque sont celles éloignées de la relation de soin mais aussi paradoxalement celles où le patient (= 5) se trouve seul confronté à des chatbots autonomes dont il ne sait pas vérifier la pertinence des réponses et dont l’usage favorise l’automédication, avec toutes les dérives bien connues.

Lafigure 4 tente de proposer un indicateur qui évalue le risque éthique sur les axes 2 à 6. Plus la surface est importante, plus le risque éthique d’usage de la technologie IA (axe 1) est grand.*

Les chatbots et l’IA forte autonome sont les technologies qui comportent le plus de risques, car elles sont opaques et établissent une relation directe avec le patient. Un indicateur dynamique plus précis est en cours d’élaboration avec un modèle objet d’espace vectoriel flou temporel (FVSOOM) car une pondération des axes est nécessaire.18

Sur l’axe 2, les méta-connaissances, connaissances, sont moins sensibles que les données et traces du patients.

L’axe 3 évalue la transparence des algorithmes comme plus acceptable que les boîtes noires opaques et dynamiques dont on ne maîtrise ni l’évolution ni les finalités.

L’axe 4 renumérote de 1 à 5 les niveaux de 5 à 9 de l’échelle de complexité des systèmes de Jean-Louis Le Moigne.23,16,17

L’axe 5 est évalué selon la population source des données utilisées par l’algorithme.

L’axe 6 décrit les utilisateurs. Les utilisations de l’IA les plus à risque sont celles éloignées de la relation de soin mais aussi paradoxalement celles où le patient (= 5) se trouve seul confronté à des chatbots autonomes dont il ne sait pas vérifier la pertinence des réponses et dont l’usage favorise l’automédication, avec toutes les dérives bien connues.

La

Les chatbots et l’IA forte autonome sont les technologies qui comportent le plus de risques, car elles sont opaques et établissent une relation directe avec le patient. Un indicateur dynamique plus précis est en cours d’élaboration avec un modèle objet d’espace vectoriel flou temporel (FVSOOM) car une pondération des axes est nécessaire.18

* Exemples d’utilisation de l’indice : Ex 1 : Un système à base de connaissances à règles de production d’antibiothérapie (axe 1 : courbe grise) Axes 2 à 6 = ( 2, 2, 2, 4, 3), Total = 13.Ex 2 : Chabot de prévention cardiovasculaire utilisant un algorithme deep learning sur des statistiques de population internationale destiné au patient (axe 1 : courbe noire) = (3,3,4,5,5), Total = 20.

Références

1. Vitalis A. Informatique, pouvoir et libertés, Paris, Economica, 1981, 212 p.

2. Portos JL. Le secret médical à l’épreuve du progrès des sciences et des techniques. I. La confidentialité des informations médicales. Le Concours Médical 1984;106(1):43.

3. Colloc J. Les problèmes médico-légaux posés par l’utilisation de l’informatique en médecine. CES de médecine légale. Université Lyon-1, 1985, 89 p.

4. Buchanan BG, Shortliffe ES. Rule-based expert systems, the mycin experiments of the Stanford heuristic programming project. AddisonWesley 1984, 748p.

5. Fieschi M. Aide à la décision en médecine : le système Sphinx. Application au diagnostic d’une douleur épigastrique. Thèse de médecine. Université de Marseille, 1981.

6. Le Beux P. Les systèmes experts en médecine. Thèse de médecine. Université Pierre-et-Marie-Curie, Paris-VI, 1983, 127 p.

7. Colloc J. Informatique médicale (SIAMED) application : logiciel original d’antibiothérapie médicale. Thèse de médecine. Université Lyon-1, 1985, 229 p.

8. Gascuel O. Un système expert pour la réalisation de diagnostics. Technique et science informatique 1985;4(3):359-72.

9. Partha Pratim Ray. ChatGPT: A comprehensive review on background, applications, key challenges, bias, ethics, limitations and future scope. Internet of Things and Cyber-Physical Systems 2023;3:121-54, 2667-3452.

10. Colloc J, Boulanger D, Lery N. Pour un système interactif d’aide à la décision en éthique médicale, SYSTED’94, CICG, 2-6 mai 1994, 5th International Conference on Systems Science in Health-Social Services For the Ederly and the Disabled, éd. J.-C. Rey & C. Tilquin, Genève. P. 711-17.

11. Colloc J, Lery N. A multi-expert decision support system in medical ethics. Health an System Science 1997;l1(1/1997):39-55.

12. Delfraissy JF, Ruault C. Comité consultatif national éthique : quarante ans de bioéthique en France, La Revue du Praticien 2023;73(5):477-80.

13. Lery L, Colloc J. Prise de décision dans l’éthique au quotidien. Comment décider le soin ? Santé, Décision, Management. Paris : Lavoisier 2008;11(1-2):243-54.

14. Colloc J, Lery L. Un métamodèle d’aide à la décision en éthique médicale. Santé Décision Management. Paris : Lavoisier 200811(1-2):255-74.

15. Colloc J. Santé et Big Data : l’État et les individus, impuissants face aux pouvoirs des réseaux. L’Espace politique 2015;26-2.

16. Colloc J. Une méthode d’évaluation éthique des bénéfices et des risques de l’intelligence artificielle en médecine clinique. in La Bioéthique en débat : quelle loi ? B. Boyer-Bévière, D. Dibie, A. Marais. Éd. Dalloz 2020:147-72.

17. Colloc J. L’aspect informatique de l’intelligence artificielle. Livre blanc Innovation digitale en santé, l’éthique au cœur 2020:25-30.

18. Colloc J, Yameogo RA, Summons P, Loubet L, Cavelier JB, Bridier P. A temporal case-based reasoning platform relying on a fuzzy vector spaces object-oriented model and a method to design knowledge bases and decision support systems in multiple domains. Algorithms 2022;15(2):66.

19. Shen Y, Colloc J, Jacquet-Andrieu A, Lei K. Emerging medical informatics with case-based reasoning for aiding clinical decision in multi-agent system. Journal of Biomedical Informatics 2015;56:307-17.

20. Shen Y, Yuan K, Chen D, Colloc J, Yang M, Li Y, et al. An ontology-driven clinical decision support system (IDDAP) for infectious disease diagnosis and antibiotic prescription, artificial intelligence in medicine 2018;86:20-32.

21. Yameogo RA. Risques et perspectives du Big Data et de l’intelligence artificielle : approche éthique et épistémologique. Intelligence artificielle. Thèse de doctorat informatique. Normandie Université, 2020.

22. Yameogo RA, Colloc J. Utilisation du Big Data et de l’intelligence artificielle en pratique médicale : enquête auprès des médecins havrais. Colloque Intelligence artificielle et innovation sociale. Université Bordeaux Montaigne, 27-29 mai 2021.

23. Le Moigne JL. La modélisation des systèmes complexes. Dunod, coll. Afcet Systèmes 1994. 178 p.

24. Cointe N, Bonnet G, Boissier O. Jugement éthique dans les systèmes multi-agents. ResearchGate 2016.

2. Portos JL. Le secret médical à l’épreuve du progrès des sciences et des techniques. I. La confidentialité des informations médicales. Le Concours Médical 1984;106(1):43.

3. Colloc J. Les problèmes médico-légaux posés par l’utilisation de l’informatique en médecine. CES de médecine légale. Université Lyon-1, 1985, 89 p.

4. Buchanan BG, Shortliffe ES. Rule-based expert systems, the mycin experiments of the Stanford heuristic programming project. AddisonWesley 1984, 748p.

5. Fieschi M. Aide à la décision en médecine : le système Sphinx. Application au diagnostic d’une douleur épigastrique. Thèse de médecine. Université de Marseille, 1981.

6. Le Beux P. Les systèmes experts en médecine. Thèse de médecine. Université Pierre-et-Marie-Curie, Paris-VI, 1983, 127 p.

7. Colloc J. Informatique médicale (SIAMED) application : logiciel original d’antibiothérapie médicale. Thèse de médecine. Université Lyon-1, 1985, 229 p.

8. Gascuel O. Un système expert pour la réalisation de diagnostics. Technique et science informatique 1985;4(3):359-72.

9. Partha Pratim Ray. ChatGPT: A comprehensive review on background, applications, key challenges, bias, ethics, limitations and future scope. Internet of Things and Cyber-Physical Systems 2023;3:121-54, 2667-3452.

10. Colloc J, Boulanger D, Lery N. Pour un système interactif d’aide à la décision en éthique médicale, SYSTED’94, CICG, 2-6 mai 1994, 5th International Conference on Systems Science in Health-Social Services For the Ederly and the Disabled, éd. J.-C. Rey & C. Tilquin, Genève. P. 711-17.

11. Colloc J, Lery N. A multi-expert decision support system in medical ethics. Health an System Science 1997;l1(1/1997):39-55.

12. Delfraissy JF, Ruault C. Comité consultatif national éthique : quarante ans de bioéthique en France, La Revue du Praticien 2023;73(5):477-80.

13. Lery L, Colloc J. Prise de décision dans l’éthique au quotidien. Comment décider le soin ? Santé, Décision, Management. Paris : Lavoisier 2008;11(1-2):243-54.

14. Colloc J, Lery L. Un métamodèle d’aide à la décision en éthique médicale. Santé Décision Management. Paris : Lavoisier 200811(1-2):255-74.

15. Colloc J. Santé et Big Data : l’État et les individus, impuissants face aux pouvoirs des réseaux. L’Espace politique 2015;26-2.

16. Colloc J. Une méthode d’évaluation éthique des bénéfices et des risques de l’intelligence artificielle en médecine clinique. in La Bioéthique en débat : quelle loi ? B. Boyer-Bévière, D. Dibie, A. Marais. Éd. Dalloz 2020:147-72.

17. Colloc J. L’aspect informatique de l’intelligence artificielle. Livre blanc Innovation digitale en santé, l’éthique au cœur 2020:25-30.

18. Colloc J, Yameogo RA, Summons P, Loubet L, Cavelier JB, Bridier P. A temporal case-based reasoning platform relying on a fuzzy vector spaces object-oriented model and a method to design knowledge bases and decision support systems in multiple domains. Algorithms 2022;15(2):66.

19. Shen Y, Colloc J, Jacquet-Andrieu A, Lei K. Emerging medical informatics with case-based reasoning for aiding clinical decision in multi-agent system. Journal of Biomedical Informatics 2015;56:307-17.

20. Shen Y, Yuan K, Chen D, Colloc J, Yang M, Li Y, et al. An ontology-driven clinical decision support system (IDDAP) for infectious disease diagnosis and antibiotic prescription, artificial intelligence in medicine 2018;86:20-32.

21. Yameogo RA. Risques et perspectives du Big Data et de l’intelligence artificielle : approche éthique et épistémologique. Intelligence artificielle. Thèse de doctorat informatique. Normandie Université, 2020.

22. Yameogo RA, Colloc J. Utilisation du Big Data et de l’intelligence artificielle en pratique médicale : enquête auprès des médecins havrais. Colloque Intelligence artificielle et innovation sociale. Université Bordeaux Montaigne, 27-29 mai 2021.

23. Le Moigne JL. La modélisation des systèmes complexes. Dunod, coll. Afcet Systèmes 1994. 178 p.

24. Cointe N, Bonnet G, Boissier O. Jugement éthique dans les systèmes multi-agents. ResearchGate 2016.