Présenter les données quantitatives sur la fréquence et la nature des EIG dans le système de soins ; enquêtes nationales sur les EIG, évolution dans les dix dernières années.

Connaître les définitions des termes suivants : antisepsie, asepsie, désinfection, décontamination, stérilisation.

Connaître les procédures d’hygiène des mains en milieu de soins, et d’antisepsie de la peau saine, de la peau lésée et des muqueuses.

Connaître et expliquer les mesures préventives des infections associées aux soins (IAS) : infection urinaire, infection sur cathéter vasculaire, pneumonie, infection du site opératoire.

Exposer les grands principes d’organisation de la sécurité sanitaire.

Définir et pondérer les grandes composantes de la gestion des risques ; préciser l’importance de la composante facteurs humains et organisationnels (FHO) du risque associé aux soins.

Préciser les différentes missions relevant du ministère chargé de la Santé et de la HAS.

Historique

En France, le contexte réglementaire dans lequel l’évaluation médicale s’est développée avait été initialement précisé par la publication d’un décret au Journal officiel du 29 décembre 1999.

Ce texte, dont la préparation s’était prolongée sur près de deux années, instaurait l’évaluation des pratiques professionnelles (EPP) des seuls médecins libéraux. Il s’agissait alors d’une procédure dans laquelle un médecin libéral s’engageait volontairement, soit à titre individuel, soit dans un cadre collectif, afin d’évaluer sa pratique clinique. Cette évaluation se décomposait en deux étapes principales : d’abord une autoévaluation par rapport à des référentiels, ensuite une visite de pairs - eux-mêmes médecins libéraux en exercice, recrutés par les unions régionales des médecins libéraux (URML). Ce sont ainsi plus d’un millier de médecins qui, entre 2002 et 2005, ont accompli ce cycle d’EPP. D’un point de vue quantitatif, le bilan est modeste. Il reste que, dans le cadre de ce dispositif légal et avec le concours de structures professionnelles, des médecins libéraux sont entrés volontairement dans des cycles d’évaluation-amélioration de leurs pratiques professionnelles ; l’avancée n’est pas mince.

Depuis lors, d’autres textes légaux, en 2004 puis en 2009, ont généralisé l’évaluation des pratiques professionnelles à l’ensemble des professionnels de santé, professions médicales et auxiliaires.

Plus généralement, les concepts sur lesquels les réflexions autour de l’évaluation médicale se sont développées avaient été précisés il y a une cinquantaine d’années. Ces différentes étapes conceptuelles ont été incarnées par plusieurs maîtres à penser.

Avedis Donabedian, tout d’abord, avait jeté les bases de l’évaluation médicale dès la fin des années 1960.2 Le schéma proposé alors distinguait trois domaines : les structures (organisations ou établissements de soins par exemple), les procédures (protocoles diagnostiques ou thérapeutiques) et les résultats (exprimés notamment en termes cliniques objectifs ou subjectifs) qui pouvaient faire l’objet d’évaluations avec des indicateurs à la clé.

Deux « écoles de pensée » représentant deux environnements professionnels distincts se sont ensuite intéressées à la question de l’évaluation et de l’amélioration des compétences et des pratiques, de manière indépendante l’une de l’autre :

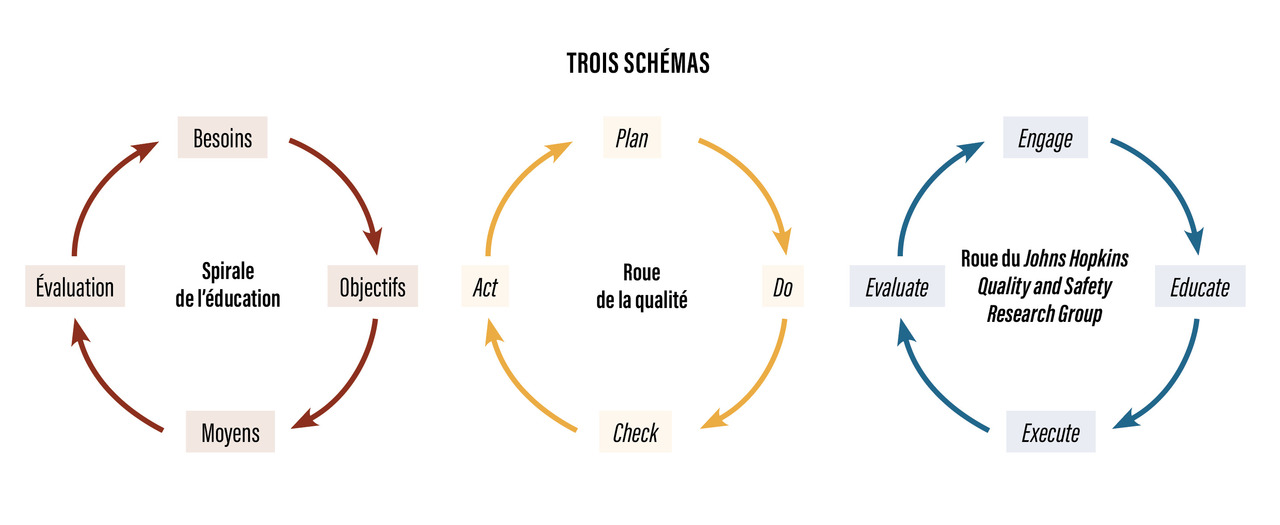

- d’une part, l’approche pédagogique (traduite par la spirale de l’éducation, prônée par l’Organisation mondiale de la Santé) développée autour des travaux réalisés par les medical educators anglo-saxons. Cette approche s’est appliquée aux médecins en formation initiale ou continue, dès lors que l’objectif a été d’évaluer la compétence des praticiens. Différents programmes expérimentaux d’analyse du raisonnement médical et de consultations simulées ont alors été réalisés par des pionniers comme Christine Mc Guire ou Howard Barrows, mais ces recherches sont restées cantonnées dans le champ limité de la formation médicale, sans relation avec le fonctionnement du système de santé ;

- d’autre part, l’approche managériale développée autour des travaux réalisés par les « qualiticiens ». Cette approche s’est appliquée au monde de l’entreprise industrielle, commerciale, puis de plus en plus à celui des services. Elle consiste principalement à analyser les processus, à établir des standards et à s’assurer que les productions sont, autant que possible, conformes aux procédures. Plusieurs experts américains ayant connu le succès et la notoriété au Japon – immense chantier de renaissance économique après la Seconde Guerre mondiale – entre 1950 et 1980, comme Deming, Crosby et Juran, ont été les chantres de cette approche (le « zéro défaut »), dont l’applicabilité au secteur de la santé a été longtemps contestée. William E. Deming est en particulier passé à la postérité comme l’initiateur de la « roue » qui porte son nom et qui fait se succéder indéfiniment les quatre étapes qui constituent la démarche générique de gestion de la qualité : P, D, C, A, pour Plan, Do, Check et Act, que l’on peut traduire par planifier, réaliser, vérifier et améliorer (

figure et encadré 1 ).

Le pédiatre Donald Berwick est la troisième personnalité qu’il faut évoquer sur la question de l’évaluation des pratiques, après Donabedian et Deming. Voilà plus de quarante ans, Berwick avait fait partie du groupe d’une vingtaine de contributeurs, représentant des secteurs très diversifiés (organisations de soins publiques ou privées, assureurs, patients, formation initiale, professions médicales et soignantes, etc.) à l’origine du rapport intitulé To err is human* (L’erreur est humaine). Sous cette formulation, l’Institute of Medicine (IOM) avait alors lancé la croisade entreprise dans les hôpitaux américains pour accroître la qualité et notamment la sécurité des soins. Le rapport To err is human est toujours disponible sur le site de l’IOM (www.iom.edu), notamment dans sa version courte. Il établit un bilan sans concession : ce sont près de 50 000 malades (et peut-être beaucoup plus, de l’ordre du double) qui, chaque année (dans les hôpitaux américains), sont victimes d’accidents médicaux dont les conséquences sont létales. En réalité, To err is human est le constat qui a marqué le démarrage d’une véritable politique d’amélioration de la sécurité des soins. Cette politique de sécurisation des soins s’était orientée selon quatre axes prioritaires énoncés au terme du rapport :

- développer la recherche, les outils, les protocoles d’étude afin d’accroître les bases de connaissance sur la sécurité des soins ;

- identifier et ainsi pouvoir apprendre des erreurs et des accidents, en organisant une obligation de signalement à l’échelle de pays et en encourageant les professionnels à participer à ce signalement ;

- engager l’ensemble des professionnels soignants ainsi que les gestionnaires et les administrations dans une dynamique d’amélioration de la sécurité des soins ;

- sécuriser, dans les organisations, dans les services, dans les unités, les pratiques de soins.

D’autres initiatives avaient également été prises, notamment par les responsables des formations de spécialités médicales (l’équivalent de nos coordonnateurs de diplômes d’études spécialisées [DES] de médecine) et par les responsables de la formation des infirmiers, conjointement. Leurs conclusions, accessibles sur le site www.cogme.org, recommandent de développer les approches communes (ou coordonnées) aux médecins et aux infirmiers, tant en matière de formation que de pratique.

Ultérieurement, et en particulier à partir de 2004, Donald Berwick a été extrêmement attentif à simplifier les messages sur l’évaluation et l’amélioration de la qualité des soins (

Et, en juin 2005, Donald Berwick avait encore intensifié son engagement pour la simplification. Pour cela, il avait signé dans Annals of Internal Medicine – l’une des revues médicales scientifiques internationales dont l’impact factor est le plus élevé, un article titré My right knee (« Mon genou droit ») où il expliquait sobrement ce que devait signifier pour un malade la qualité des soins.1 Loin du discours théorique, il donnait une définition de la « qualité absolue », alors qu’il était contraint d’envisager une intervention chirurgicale pour substituer une prothèse à son genou déficient. Cette définition comportait les cinq dimensions suivantes adressées aux équipes soignantes et gestionnaires : « Évitez autant que possible de me tuer », « Soutenez-moi et soulagez mes douleurs », « Veillez à ce que je ne me sente pas abandonné », « Ne me faites pas attendre » et « Ne gaspillez pas les ressources dont vous disposez ».

Ainsi se trouvaient résumées en quelques mots les attentes d’un patient – par ailleurs médecin lui-même et largement impliqué dans les politiques mises en œuvre ces cinquante dernières années – au moment de s’abandonner entre les mains d’une équipe chirurgicale. En janvier 2008, Donald Berwick a complété son ouvrage simplificateur. Changeant de registre – et s’adressant cette fois beaucoup plus aux chercheurs et aux méthodologistes qu’aux cliniciens –, il a commis, dans le Journal of the American Medical Association (JAMA), un court article consacré à The science of improvment (la science de l’amélioration).4 Il y cite largement deux auteurs anglais qui, dès 1997, avaient perçu l’essoufflement des innombrables stratégies et actions d’amélioration de la qualité, dans lesquelles les médecins et les équipes soignantes étaient appelés à s’engager. Ces auteurs avaient également anticipé la relative incapacité de ces stratégies à objectiver des améliorations pertinentes et surtout à établir la relation causale entre l’effet observé et les innovations introduites. Pour conclure, Donald Berwick, fort de la légitimité que confère l’expérience acquise, énonce quatre évolutions fortes, susceptibles d’accroître l’efficacité des politiques d’amélioration de la qualité. Il y insiste en particulier sur les points suivants :

- diversifier le plus possible les méthodes scientifiques pour conduire des programmes d’amélioration des pratiques, et recourir aux méthodes qualitatives classiquement réservées aux sciences humaines ;

- ne pas être victime de la dictature des seuils de significativité statistique pour valider ou rejeter les solutions testées ; privilégier plutôt les approches pragmatiques comme celle chère à W. E. Deming (planifier, faire, vérifier, adapter) ;5

- ne pas attacher une importance excessive au contrôle des biais possibles ; ils existent et font partie intégrante des conditions d’exercice quotidien ; accorder toute l’importance possible à maintenir la cohésion, le respect et l’estime entre les équipes de recherche et les équipes de soignants qui assurent la prise en charge des malades sur le terrain tous les jours. Dont acte.

Les trois motivations de l’évaluation des pratiques

C’est pourquoi, dès le début des années 1990, un mouvement pour l’évaluation des pratiques médicales s’est progressivement imposé dans l’ensemble des pays développés. À son origine, on recense trois motivations principales, portées par trois catégories distinctes d’acteurs du système de santé.

La première motivation a été portée par les gestionnaires et financeurs et s’est naturellement intéressée à une évaluation fondée sur des approches économiques, financières et, le cas échéant, organisationnelles et managériales. C’est dès la fin des années 1980, au moment où le coût de la santé a commencé à devenir significatif, que cette première motivation s’est manifestée. Elle n’a pas cessé depuis. Et il faut noter que cette motivation économique et managériale a été portée autant dans les pays libéraux ou ultralibéraux (États-Unis) que dans ceux où le système de soins était partiellement ou même complètement étatisé (Royaume-Uni).

La deuxième motivation a été portée par les patients et les associations qui les représentent, et s'est évidemment intéressée à une évaluation fondée sur les perceptions des malades et sur les conditions d’accès aux soins. On a pu croire – surtout en aval de la loi « droits des malades » votée en 2002 – que cette motivation allait de pair avec une judiciarisation croissante de la pratique médicale ; en réalité, il n’en est rien, selon les données publiées chaque année par l’Office national d’indemnisation des accidents médicaux (ONIAM), le nombre des contentieux étant stable. Il reste que, de plus en plus largement, les malades et la population générale considèrent que la sécurité, tout comme la qualité des soins qu’ils reçoivent, doit être « garantie ».

La troisième motivation a été portée par les médecins et l’ensemble des professions de santé : cette motivation s’est exprimée avec retard par rapport aux deux précédentes, tant les médecins ont considéré avec méfiance l’obligation où ils se trouvaient de justifier le bien-fondé de leurs pratiques ; au risque, de surcroît, d’encourir les sanctions qui étaient prévues par le dispositif légal et réglementaire. Les choses ont changé après le début des années 2000, quand la dimension sanction a été explicitement récusée et surtout dès lors que l’idée de l’évaluation a été extraite de dispositifs dédiés, d’essence bureaucratique, pour s’intégrer dans de nouvelles organisations de l’exercice clinique (comme les réunions de concertation pluridisciplinaire en cancérologie). L’implication croissante des médecins – et des autres professionnels (pour qui l’idée d’évaluation était souvent plus familière) – a permis de « médicaliser » les critères sur lesquels pouvait se fonder l’analyse des pratiques.

Pour autant, il persiste une sorte de compétition ou même de confusion entre les différents critères portés par les trois motivations distinctes identifiées ci-dessus. C’est pourquoi l’évaluation en santé conserve un aspect « à facettes » et le cas échéant complexe.

Évaluation et qualité des pratiques : trois options

Cette tendance forte n’est pas propre à la France. Des objectifs de qualité de pratique des professionnels et de sécurité des soins aux patients sont maintenant affichés comme des priorités dans la plupart des pays développés. D’autant qu'ils constituent maintenant le rationnel des « rémunérations à la performance » proposées aux professionnels (p. ex., le pay for performance [P4P] des Anglo-Saxons).

De leur côté, les médecins sont évidemment attentifs à la qualité de leur pratique, mais l’explicitation de cette attention ne va pas nécessairement de soi.

La question est donc de préparer un cadre permettant à la profession médicale de faire état de la qualité de ses pratiques et, pour ce qui concerne les politiques d’amélioration des pratiques, deux grandes options sont aujourd’hui en discussion dans l’ensemble des pays dotés d’un système de santé développé (périmètre qui peut être circonscrit aux pays de l’Organisation de coopération et de développement économiques [OCDE]).

La première option, qui bénéficie d’une antériorité certaine, est caractérisée par la mise en œuvre de dispositifs visant à s’assurer du respect, par chaque médecin sur une période donnée (par exemple cinq ans), d’un ensemble de critères apportant des éléments de garantie sur la qualité de la pratique médicale.

Au premier rang de ces démarches, on trouve – classiquement – les activités d’actualisation des connaissances et plus largement la formation médicale continue. Une quantification de ces activités a été progressivement élaborée, permettant l’attribution de points (ou de credits chez les Anglo-Saxons). En France, ces obligations ont pris rang sous différentes formes successives : formation médicale continue (FMC), évaluation des pratiques professionnelles (EPP), développement professionnel continu (DPC).

Cette première option a connu deux évolutions sensibles ces quinze dernières années (motivées par l’insuffisance6,7 des résultats obtenus). D’abord, la pédagogie de la formation continue s’est déplacée de la transmission des connaissances vers la résolution de problèmes pratiques. Ensuite, la formation continue a été associée à d’autres dimensions comme, pour chaque médecin, des enquêtes d’opinion auprès d’échantillonnages de malades et de collègues, complétées par des visites de pairs permettant d’évaluer la pratique (et le plus souvent justifiées par la répétition d’incidents), à partir de la capacité de résoudre des problèmes cliniques simulés (accessibles sur internet), ou encore sur l’obtention de distinctions professionnelles ou scientifiques en cours de carrière. Chacune de ces activités pouvait faire l’objet d’attribution de nouveaux credits, traduit dans des barèmes complexes, conditionnant éventuellement l’obtention d’une recertification professionnelle. Le défaut de recertification exposant à des sanctions** (en réalité, jusqu’à maintenant rarement mises en œuvre).

Avec le recul dont on peut bénéficier aujourd’hui, cette première option et notamment la recertification à l’américaine n’est pas considérée pour le moment comme une pleine réussite ; essentiellement pour les deux raisons suivantes :

- en premier lieu, le respect des critères de recertification ne garantit pas de manière stable et fiable la qualité de la pratique « en routine sur le terrain » du médecin concerné. Avant tout parce que cette pratique dépend moins du savoir et de la compétence individuels que des conditions d’exercice (contexte et organisation professionnelle) ;

- en second lieu, les dispositifs de formation continue et les éventuelles procédures de recertification restent invariablement perçus par les médecins comme des entités autonomes et indépendantes de leur exercice, comme des « objets en soi » constituant leur propre finalité, sans que leur pratique quotidienne en soit durablement impactée.

La deuxième option correspond à des initiatives plus récentes, promues principalement par des équipes médicales (bénéficiant d’un soutien logistique), et le cas échéant par des managers financeurs, moins attachés à une approche pédagogique ou une sensibilité académique et davantage inspirés par une préoccupation d’amélioration constante de l’organisation de l’exercice et des résultats cliniques.

Ces initiatives ont comme point commun d’analyser les pratiques en matière de résultats cliniques obtenus avec les malades, ou a minima en matière de conditions de mise en œuvre de protocoles de prise en charge des patients, le cas échéant continuellement réadaptés à la lumière de l’expérience acquise. Elles se traduisent toutes par des programmes de prise en charge de malades, de manière à obtenir des résultats supérieurs à ce qui est habituellement observé.

Au jour le jour, de tels programmes de bonnes pratiques peuvent être structurés autour de « méthodes » comme les groupes de pairs en médecine générale, les réunions de concertation pluridisciplinaire notamment en cancérologie, les staffs de morbi-mortalité dans les services hospitaliers, ou plus généralement toute activité clinique qui bénéficie de la tenue d’un « registre » dont les données sont continuellement soumises à l’analyse.

Cette deuxième option est en train de démontrer sa bonne acceptabilité, son économie de moyens et surtout son efficacité, au point que les plus lucides des opérateurs (dans l’ensemble des pays de l’OCDE), qui jusque-là s’investissaient dans la première option, sont en train de s’en éloigner pour se rapprocher de la deuxième. Toutefois, certaines voix s’élèvent tant du côté des gestionnaires du système de santé que des usagers pour dénoncer certaines limites, notamment quant à l’implication réelle et non quantifiable des professionnels et à la modification effective des pratiques et surtout des résultats.

Une troisième option est prônée par Donald Berwick en personne,8 qui dénonce le conflit entre, d’une part, les tenants de la « romance de l’autorégulation professionnelle » (sic) et, d’autre part, l’impérieux devoir des professionnels dans tous leurs rôles, y compris les éducateurs professionnels, de suivre et de répondre aux questionnements licites de la société et de ce qu’elle attend de leur travail. Et d’ailleurs, toujours selon Berwick, qui ne voudrait pas que les professionnels, qui engagent un septième de l’économie américaine, se demandent continuellement dans quelle mesure ils répondent aux besoins de la société ? La réponse est pour lui clairement en faveur d’une autorégulation professionnelle encadrée par une responsabilité extérieure à la profession.

La France est en avance sur ce point. En effet, elle a développé depuis 2005 un tel programme : c’est l’accréditation des médecins et équipes médicales (pour le moment sont uniquement concernées les disciplines chirurgicales, interventionnelles et anesthésique). Il s’agit d’un programme proposé par des pairs (les organismes agréés d’accréditation de la spécialité) et encadré sur le plan logistique et scientifique de manière indépendante de la profession, par la Haute Autorité de santé qui, in fine, délivre un certificat d’accréditation à tous les médecins ayant validé leur programme de spécialité et une attestation aux équipes qui l’ont réalisé (mono- ou pluridisciplinaire et aussi pluriprofessionnelle). Dans sa version actuelle, l’accréditation permet indéniablement d’améliorer le travail en équipes, l’évaluation/amélioration des pratiques et la sécurité des patients, au moyen des « méthodes » telles celles proposées dans l’option 2. Il s’agit d’un programme continu (et non ponctuel), intégré au travail au quotidien (et non détaché de l’exercice) avec une logique ancrée dans l’établissement. Ce programme permet le maintien des compétences, voire l’acquisition de nouvelles. Dans sa nouvelle version, il comporte également des aspects plus novateurs mais essentiels de la qualité comme la santé des professionnels (élément impactant) et la relation avec les patients. Ce programme qui existe depuis quinze ans est maintenant mature, et de nombreux succès sont à mettre à son actif : il permet une évaluation à grande échelle des pratiques entre pairs, l’intégration de la culture sécurité dans le quotidien des professionnels, l’appropriation des sujets sécurité du patient par les collèges professionnels... et la création d’une base de retours d’expérience unique, à partir de laquelle peuvent être tirés des enseignements pour la sécurité des patients.

Qualités d’une évaluation (des pratiques)

Ainsi, les cinq qualités (ou caractéristiques) que doivent autant que possible présenter une évaluation et les indicateurs qui la matérialisent sont (en faisant la part belle aux néologismes) : l’acceptabilité, la faisabilité, la fiabilité, la sensibilité et (surtout) la validité. Ces différents critères sont déterminants dès lors qu’il s’agit de mettre en œuvre une procédure d’évaluation-amélioration (

Dans ces conditions, leur bonne acceptabilité (de même que la faisabilité suffisante de la mise en œuvre) est une condition du bon déroulement de l’évaluation ; en pratique, cela signifie que les indicateurs doivent être aisément disponibles et autant que possible déjà saisis et disponibles dans un système d’information.

Le fait que les indicateurs permettent des appréciations fiables, c’est-à-dire stables et reproductibles, est également important, d’autant que l’évaluation sera suivie de décision(s).

Enfin, ces indicateurs doivent être sensibles pour détecter les variations aussitôt qu’elles se produisent et avant tout valides – c’est-à-dire reflétant bien ce que l’évaluation cherche à appréhender.

En pratique, quelles que soient ses autres qualités, une évaluation dont la validité serait insuffisante – c’est-à-dire qui ne traduirait pas correctement l’objet à évaluer – ne devrait pas être mise en œuvre. Ainsi, une démarche qualité peut contribuer efficacement à l’amélioration des pratiques des professionnels et des résultats des soins.

Perspectives

POINTS FORTS À RETENIR

L’évaluation des pratiques professionnelles est une demande explicite et légitime des patients et des gestionnaires du système de santé. C’est également un souci éthique des médecins, toujours attentifs à la qualité des soins qu’ils prodiguent et à la sécurité de leurs patients.

Cette démarche est à l’évidence vertueuse tant il est vrai que l’on ne peut améliorer que ce que l’on évalue. On ne peut pas dire que cette dimension de la pratique soit entrée dans la routine des médecins en 2023. Cependant, les choses évoluent. On assiste à une prise de conscience par les médecins eux-mêmes de cette ardente obligation. Et il s’agit bien davantage d’un changement de culture et de valeurs professionnelles que d’une simple modification légale ou d’une quelconque obligation réglementaire.

Les pionniers avaient jeté les bases méthodologiques de l’évaluation avec une typologie des indicateurs (structure, processus et résultats intermédiaires et finaux). Une nouvelle génération a proposé une approche pragmatique avec notamment la fameuse roue de la qualité de Deming. Toutes ces démarches sont « théorisées » dans ce qu’il est de coutume d’appeler « the science of improvment », en gardant bien à l’esprit que les méthodes peuvent être différentes de l’évaluation scientifique traditionnelle et embrasser plus largement les autres disciplines, ainsi les sciences socio-ethnographiques.

Le « déclencheur » de ce mouvement irréversible a indéniablement été la publication aux États-Unis du rapport « To err is human », avec le constat affligeant de plus de 50 000 décès annuels par accidents médicaux, qui a provoqué la création de nombre de plans d’actions et programmes déclinés dans tous les pays.

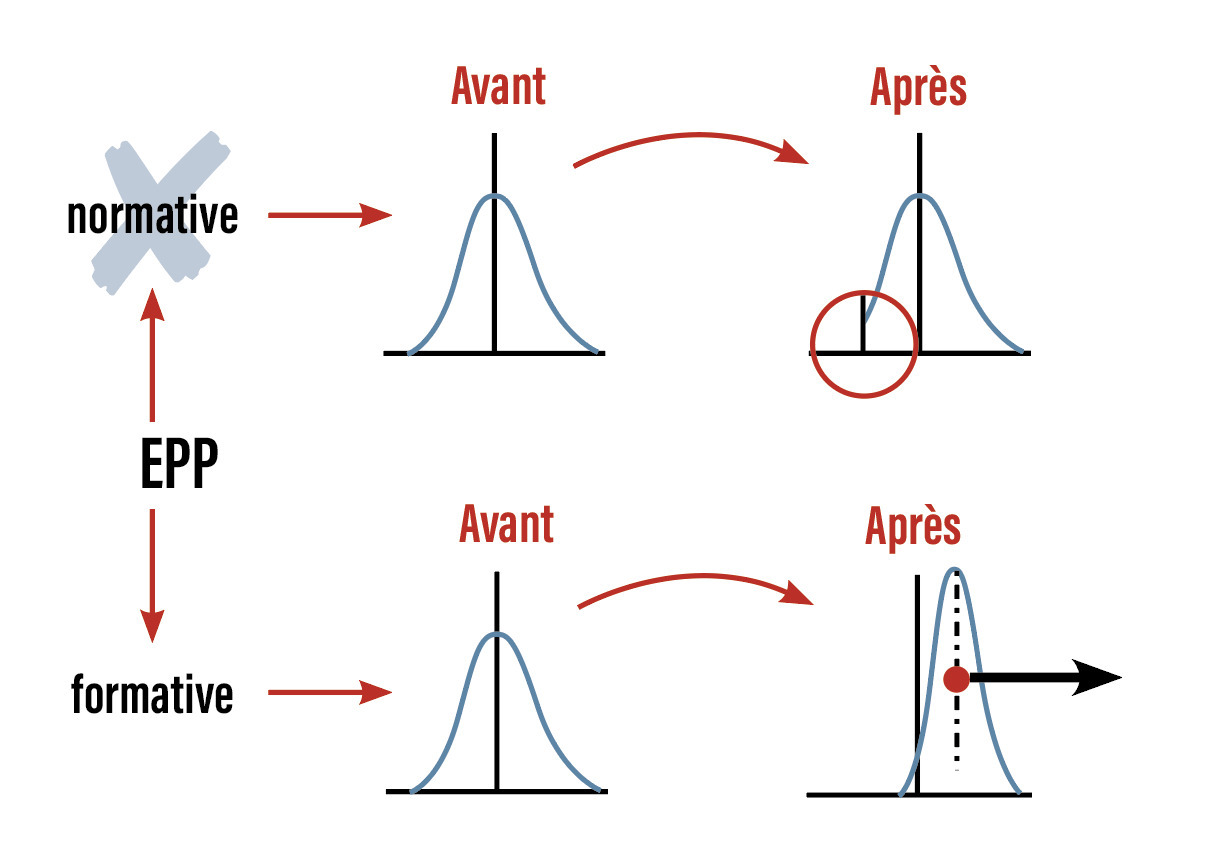

L’EPP – ainsi est appelée l’évaluation des pratiques professionnelles en France – a été proposée en 2005 par la Haute Autorité de santé (HAS) et ses partenaires professionnels sur un mode d’évaluation formative et intégrée aux pratiques, seul modèle dont l’acceptabilité et la faisabilité sont un préalable indispensable à l’utilité et l’efficacité de cette dynamique. Cette EPP a été largement portée par la procédure de certification des établissements de santé.

Cette évaluation des pratiques, appelée de leurs vœux par toutes les parties prenantes, pourrait adopter le modèle retenu comme idéal dans la littérature, à savoir celui d’une autorégulation par les professionnels, encadrée par une responsabilité extérieure à la profession. En France, nous disposons d’un tel programme : l’accréditation des médecins et équipes proposée entre pairs par des organismes agréés issus de chaque discipline et encadrée sur le plan logistique et scientifique par la HAS.

1. Assurance qualité et démarche qualité

Les courbes de la partie haute de la figure ci-contre représentent ce qui pourrait résulter si l’on appliquait à une évaluation des pratiques médicales une procédure d’« assurance qualité ». Selon cette procédure d’inspiration normative, le contrôle y intervient a posteriori et consiste à rechercher les anomalies ou les incidents de pratique de manière à les éliminer. Le résultat est évidemment de portée limitée : seuls les anomalies et les incidents les plus manifestes peuvent être identifiés, et le cas échéant corrigés. Une fois les corrections faites, la qualité moyenne ne progresse que faiblement, comme le montre la figure.

En revanche, les courbes de la partie basse peuvent montrer une évolution importante de la qualité obtenue dès lors que la démarche qualité, consistant à s’inscrire dans une démarche formative, est mise en œuvre. Cette démarche d’amélioration continue peut être résumée par quatre temps principaux qui se répètent indéfiniment : d’abord établir ce que pourrait être une démarche optimale, puis la mettre en œuvre, avant d’en analyser le déroulement et le résultat, enfin rechercher les améliorations possibles et les mettre en œuvre… indéfiniment. C’est pourquoi on peut préférer une approche « formative » à une approche « normative ».

En réalité, la distribution « normale » telle qu’elle a été décrite par le physicien allemand Johann Gauss à la fin du XIXe siècle correspond plus précisément à la « distribution des mesures répétées d’un même phénomène ou objet physique avec le même instrument » ; la dispersion du résultat des mesures effectuées ne traduit donc que la seule variation due au hasard. Ainsi, la courbe qui représente cette distribution normale est unimodale, symétrique et en forme de cloche.

C’est donc par extension et par commodité qu’il est généralement admis que la plupart des phénomènes cliniques observables et mesurables se repartissent suivant des distributions normales.

2. Les conseils de Berwick pour l’évaluation et l’amélioration de la qualité de soins

Donald M. Berwick avait signé, en 2004, dans le British Medical Journal9 un très court article où il faisait part de sa longue expérience. Cet article se termine par neuf conseils adressés à tous ceux qui souhaitent s’impliquer dans l’évaluation et l’amélioration de la qualité des soins. Ces conseils, listés ci-dessous, devraient rester présents à l’esprit de tous, en particulier au moment de la généralisation de l’évaluation des pratiques médicales :

- Simplifier tout ce qui peut l’être ; l’amélioration de la qualité n’a pas vocation à être compliquée

- Attacher toute l’importance souhaitable à la notion d’équipe

- Être pragmatique quand il s’agit de mesurer (d’évaluer)

- Limiter les aspects organisationnels au strict minimum

- Ne pas négliger les aspects politiques

- Aider les patients à jouer un rôle

- Aller vite, commencer maintenant (et petit)

- Diffuser et s’étendre continuellement

- Et, surtout, ne pas se plaindre !

3. Démarche qualité et évaluation des pratiques : les méthodes

Quand, au cours des années 1990, la nécessité d’une évaluation des pratiques (de leur efficacité, de leur utilité…) est devenue de plus en plus explicite, il a été manifeste que les médecins étaient privés des deux composantes à partir desquelles s’élabore toute évaluation : d’une part, les données et, d’autre part, les référentiels. Les données correspondent à tout ce qui constitue la traçabilité des actes médicaux, et particulièrement les données cliniques, le diagnostic, les traitements et leurs effets. En effet, ces données étaient alors quasi exclusivement manuscrites dans des dossiers papier, et donc difficilement exploitables. Les référentiels correspondent à ce qui décrit la prise en charge idéale d’un malade ; l’evidence based medicine était balbutiante et ces référentiels commençaient tout juste à être produits (et à provoquer défiances et suspicions …). C’est pourquoi sont apparues les « méthodes » d’évaluation. La plus connue de ces méthodes est l’audit clinique, formalisée par le britannique C. D. Shaw, dès 1989. Elle consiste à pallier les deux déficits qui prévalaient à l’époque : la disponibilité des données et l’existence de référentiels (ou du moins d’un critère auquel les données peuvent être comparées). Ainsi, la méthode « audit » comporte six étapes principales :

- le choix du sujet ;

- l’identification ou même l’élaboration du référentiel (ou des critères) ;

- le recueil des données (en « fouillant » dans les dossiers) ;

- la comparaison de ces données avec le référentiel ;

- l’identification et la quantification des écarts ;

- les mesures correctrices (afin de réduire les écarts).

En réalité, cette méthode d’audit n’est qu’une application de la démarche qualité figurée par la « roue de Deming » et ses quatre étapes Plan, Do, Check, Act. Et le même constat peut être fait pour la plupart des « méthodes » d’évaluation développées par les qualiticiens tout au long des années 1990. Toutes sont des applications de la roue de Deming, à des degrés de sophistication variables. Ainsi en est-il du « suivi d’indicateurs » où l’évolution de certaines données cliniques prédéterminées est analysée en fonction de la manière dont sont pris en charge les malades. Ainsi en est-il également de la méthode « pertinence des actes » où cette pertinence est évaluée a posteriori, en comparant ce qui a été fait à ce qui aurait pu être fait si les référentiels avaient été respectés. Dans tous les cas, il s’agit d’analyser les données d’une prise en charge d’un malade avec un référentiel, a priori ou a posteriori. Une quinzaine d’années plus tard, ces méthodes d’évaluation ont vocation à se diluer dans l’exercice quotidien des médecins et des soignants pour les deux raisons suivantes : d’abord, les données de l’activité clinique sont en train de devenir enfin accessibles et manipulables, grâce au développement de l’informatique sur le bureau des professionnels. Ensuite, les référentiels de pratique, sous des formes de plus en plus accessibles, adaptables et intégrés à la pratique, se multiplient.

2. Donabedian A. Evaluating the quality of medical care. The Milbank Memorial Fund Quarterly 1966;44(3):166-203.

3. Pronovost P, Needham D, Berenholtz S, Sinopoli D, Chu H, Cosgrove S, et al. An intervention to decrease catheter-related bloodstream infections in the ICU. N Engl J Med 2006;355(26):2725-32.

4. Berwick DM. The science of improvement. JAMA 2008;299:1182-4.

5. Chabot JM. L’unicité de la roue. Rev Prat 2004;54:2273-4.

6. Marinopoulos SS, Dorman T, Ratanawongsa N, Wilson LM, Ashar BH, Magaziner JL, et al. Effectiveness of continuing medical education. Evid Report Technol Assess 2007;149:1-69.

7. Fletcher S. Pharma and CME: View from the US. BMJ 2008;a1023.

8. Berwick DM. Postgraduate education of physicians: Professional self-regulation and external accountability. JAMA 2015;313(18):1803-4.

9. Berwick DM. Lessons from developing nations on improving health care. BMJ 2004;328:1124-9.

Encadrés

Encadrés